基于融合C3SE+YOLOv5s的高精度二维码检测识别分析系统

创始人

2024-05-09 11:49:10

在前面的系列博文中,我们尝试了在不同款的yolov5模型中加入不同的注意力机制来提升模型的性能,都有不错的表现效果,本文主要的目的是尝试将注意力机制融合集成进入原生的C3模块中来替换原生的C3模块来对比分析模型的检测性能,首先看下效果图:

这里的检测对象只有一个就是:qrcode(二维码)。

改进后的模型文件如下:

#Parameters

nc: 1 # number of classes

depth_multiple: 0.33 # model depth multiple

width_multiple: 0.50 # layer channel multiple

anchors:- [10,13, 16,30, 33,23] # P3/8- [30,61, 62,45, 59,119] # P4/16- [116,90, 156,198, 373,326] # P5/32#Backbone

backbone:# [from, number, module, args][[-1, 1, Conv, [64, 6, 2, 2]], # 0-P1/2[-1, 1, Conv, [128, 3, 2]], # 1-P2/4[-1, 3, C3SE, [128]],[-1, 1, Conv, [256, 3, 2]], # 3-P3/8[-1, 6, C3SE, [256]],[-1, 1, Conv, [512, 3, 2]], # 5-P4/16[-1, 9, C3SE, [512]],[-1, 1, Conv, [1024, 3, 2]], # 7-P5/32[-1, 3, C3SE, [1024]],[-1, 1, SPPF, [1024, 5]], # 9]#Head

head:[[-1, 1, Conv, [512, 1, 1]],[-1, 1, nn.Upsample, [None, 2, 'nearest']],[[-1, 6], 1, Concat, [1]], # cat backbone P4[-1, 3, C3SE, [512, False]], # 13[-1, 1, Conv, [256, 1, 1]],[-1, 1, nn.Upsample, [None, 2, 'nearest']],[[-1, 4], 1, Concat, [1]], # cat backbone P3[-1, 3, C3SE, [256, False]], # 17 (P3/8-small)[-1, 1, Conv, [256, 3, 2]],[[-1, 14], 1, Concat, [1]], # cat head P4[-1, 3, C3SE, [512, False]], # 20 (P4/16-medium)[-1, 1, Conv, [512, 3, 2]],[[-1, 10], 1, Concat, [1]], # cat head P5[-1, 3, C3SE, [1024, False]], # 23 (P5/32-large)[[17, 20, 23], 1, Detect, [nc, anchors]], # Detect(P3, P4, P5)]

这里是以yolov5s为基准模型进行改进的,当然了如果想使用其他系列的模型也都是可以的,对照着处理即可。

接下来看下数据情况:

YOLO格式标注数据如下:

实例标注数据如下:

0 0.773846 0.567164 0.089231 0.216418VOC格式标注数据如下:

实例标注数据如下:

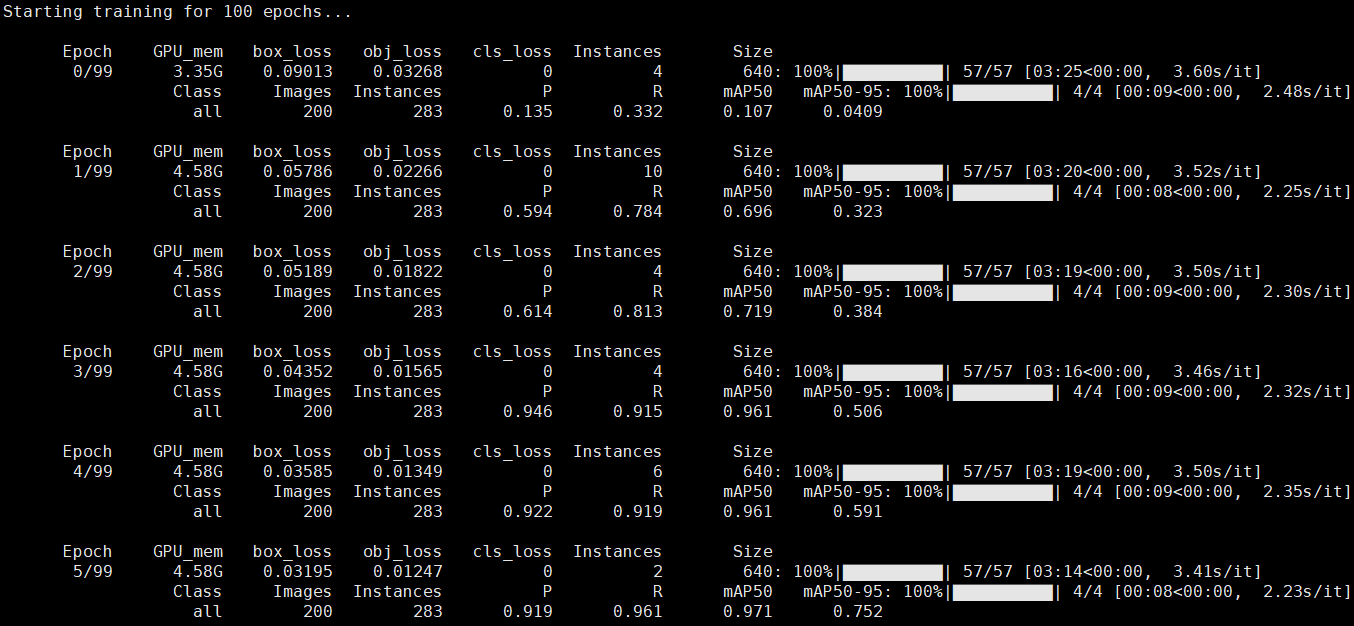

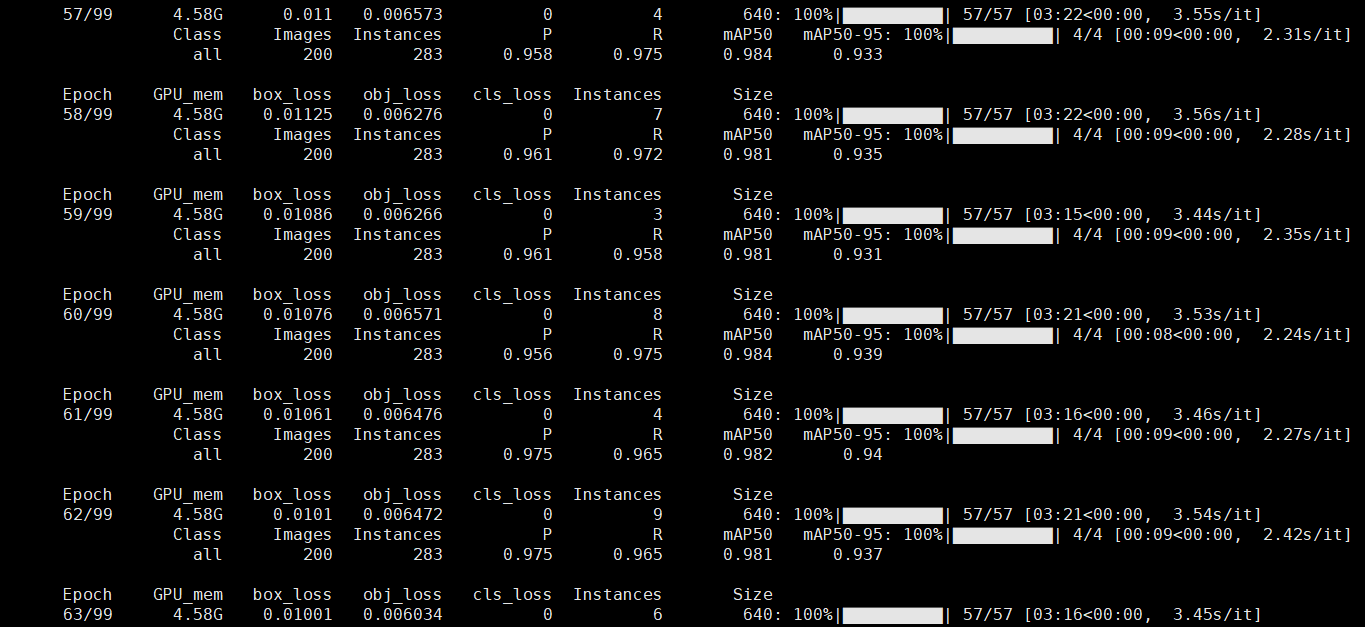

qrcode 0afd2122-041f-48d2-af22-3e1ffb0dfecc.jpg The qrcode Database qrcode qrcode CGB 1000 1030 3 0 默认执行100次epoch的迭代计算,基于GPU模式完成训练,日志输出如下所示:

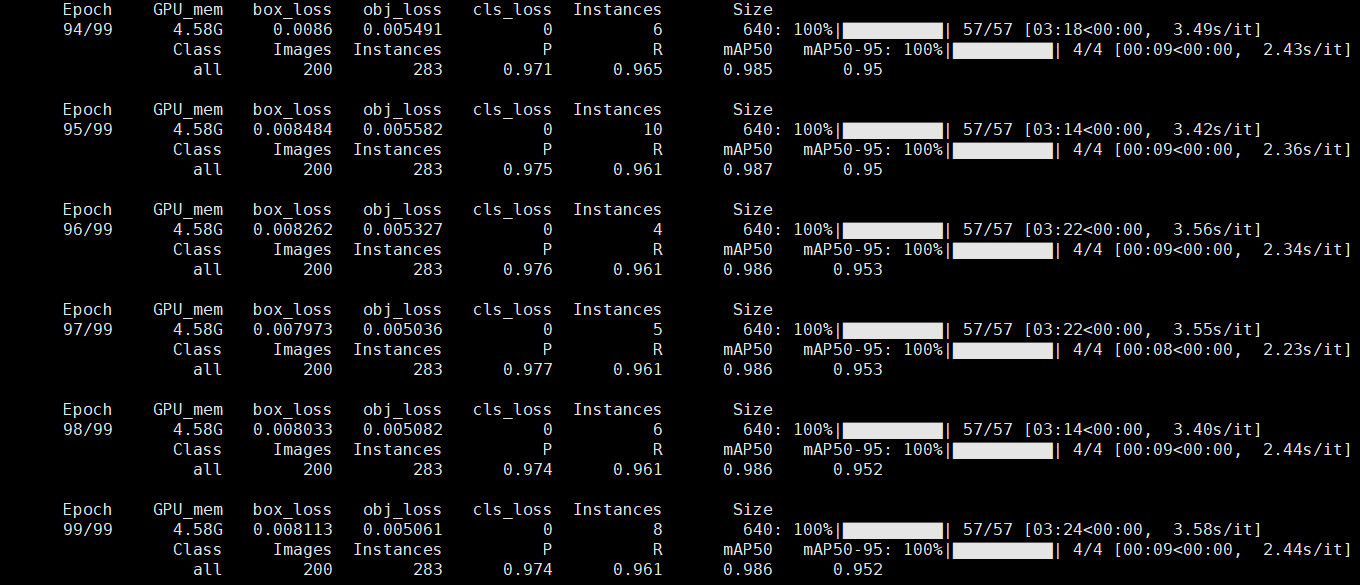

训练完成后结果数据文件如下:

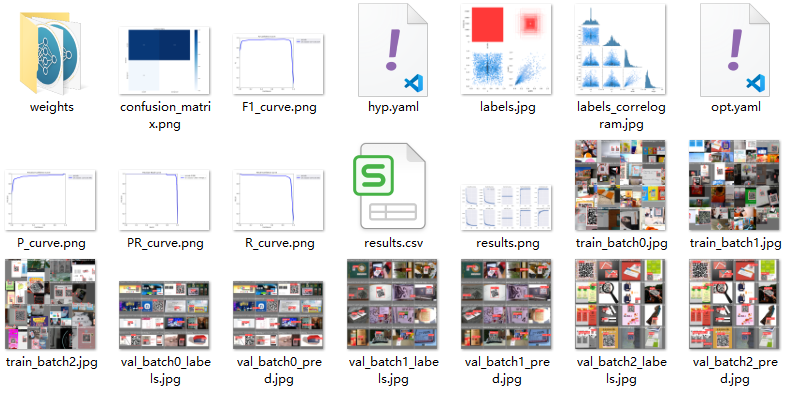

标签可视化如下:

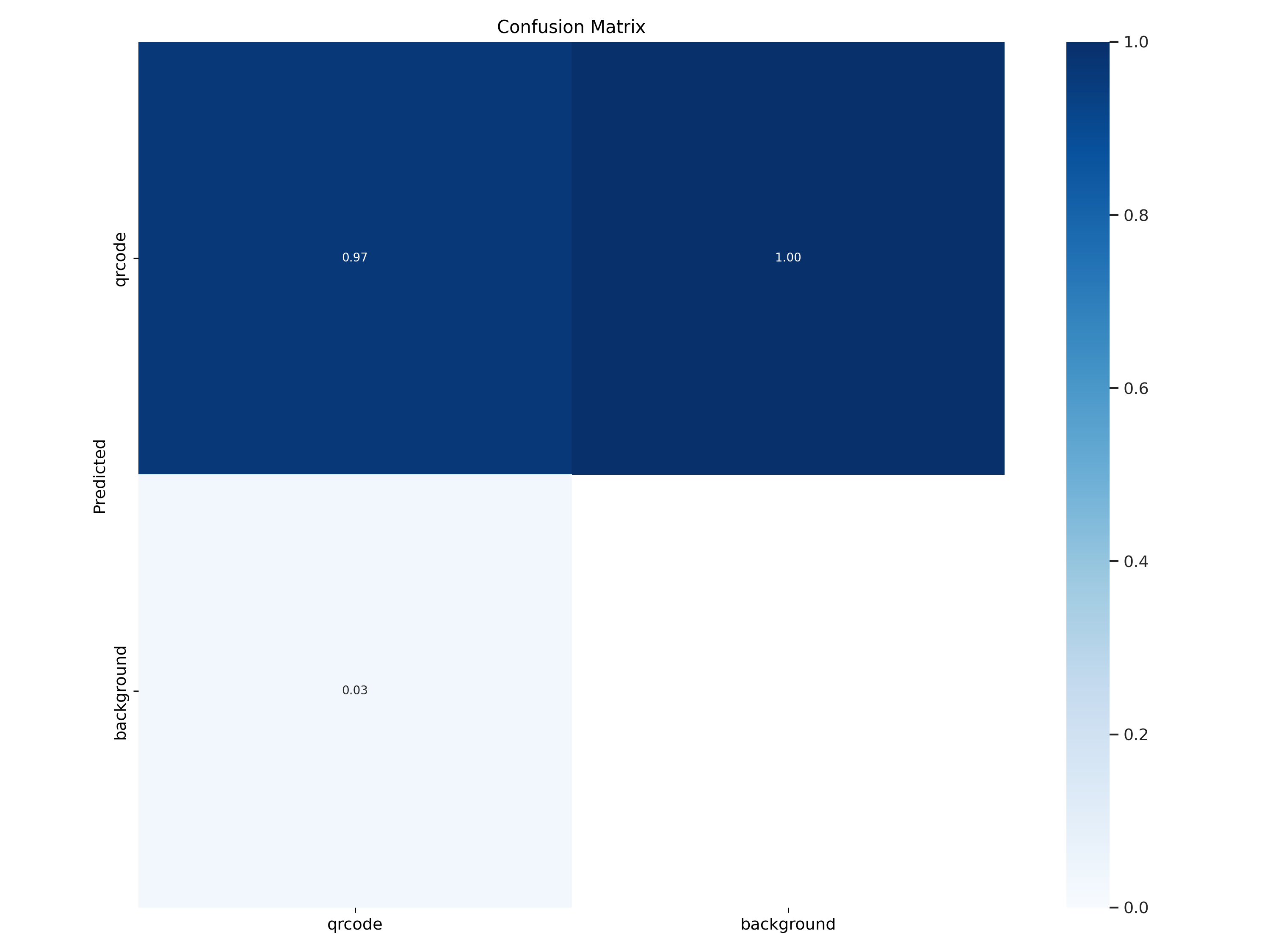

混淆矩阵如下:

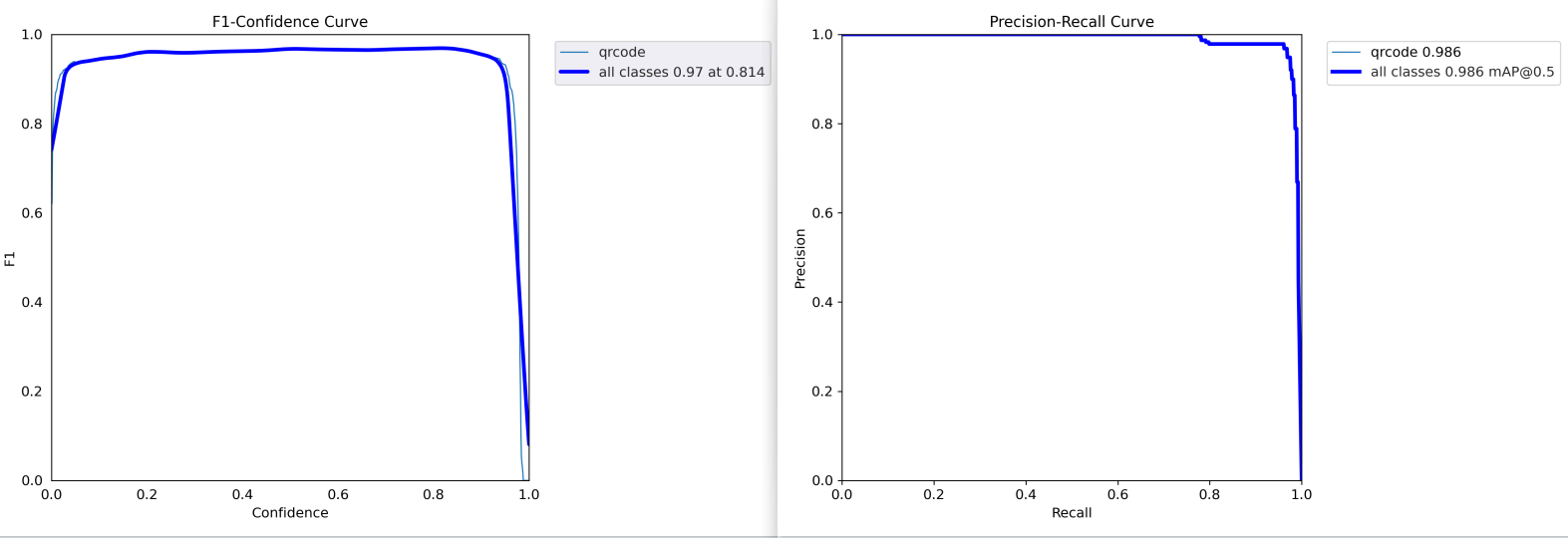

F1值曲线和PR曲线如下:

训练batch检测实例如下:

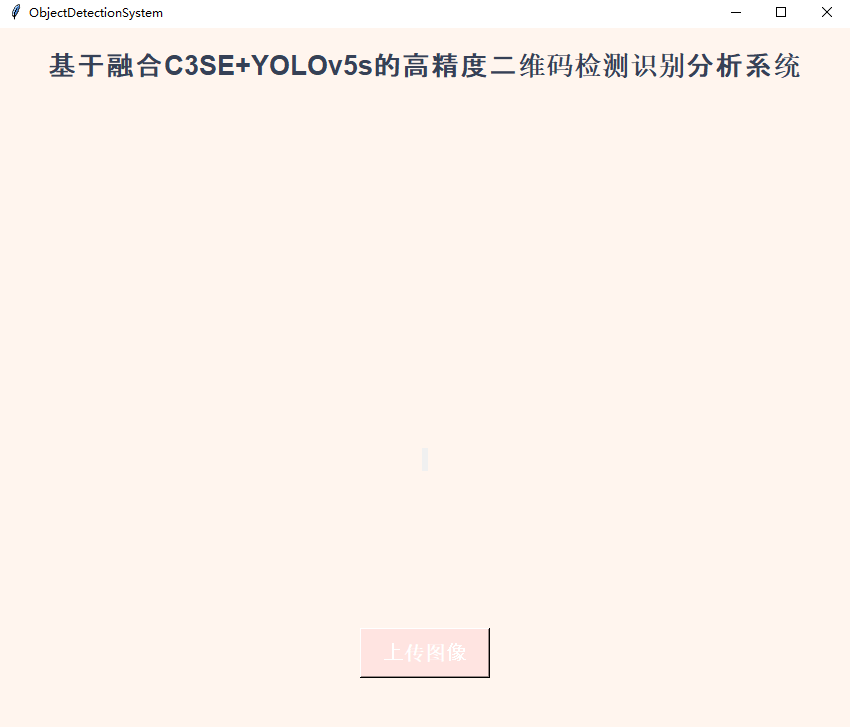

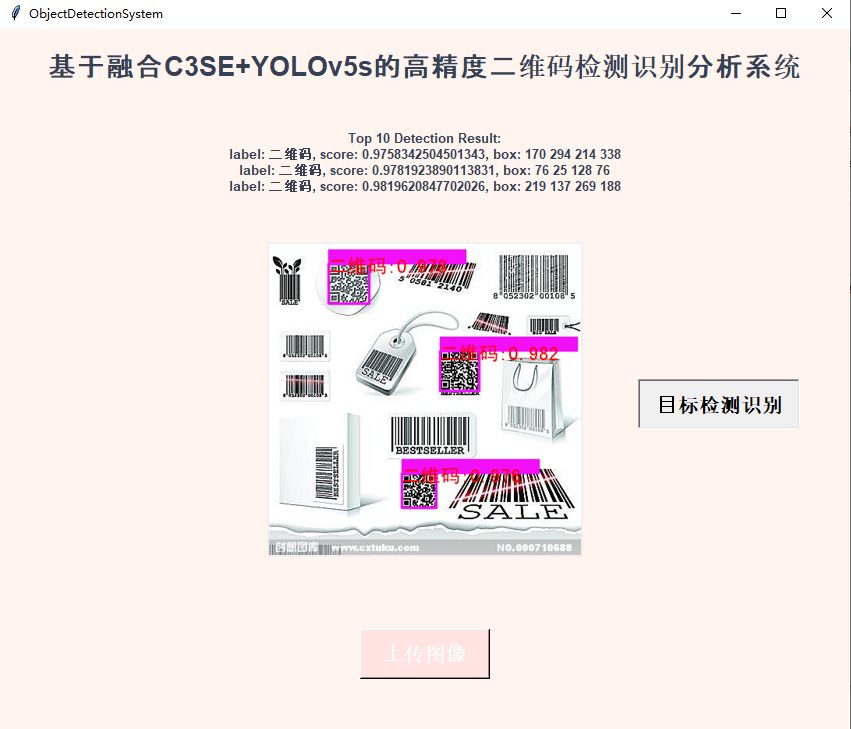

基于专用界面实现推理可视化如下:

上传待检测图像:

推理检测如下:

上一篇:【十分钟学懂Linux操作系统】

下一篇:_Linux多线程-基础篇

相关内容

热门资讯

脚上的穴位图 脚面经络图对应的...

人体穴位作用图解大全更清晰直观的标注了各个人体穴位的作用,包括头部穴位图、胸部穴位图、背部穴位图、胳...

demo什么意思 demo版本...

618快到了,各位的小金库大概也在准备开闸放水了吧。没有小金库的,也该向老婆撒娇卖萌服个软了,一切只...

北京的名胜古迹 北京最著名的景...

北京从元代开始,逐渐走上帝国首都的道路,先是成为大辽朝五大首都之一的南京城,随着金灭辽,金代从海陵王...

苗族的传统节日 贵州苗族节日有...

【岜沙苗族芦笙节】岜沙,苗语叫“分送”,距从江县城7.5公里,是世界上最崇拜树木并以树为神的枪手部落...

长白山自助游攻略 吉林长白山游...

昨天介绍了西坡的景点详细请看链接:一个人的旅行,据说能看到长白山天池全凭运气,您的运气如何?今日介绍...