李宏毅:Life Long Learning

Life Long Learing 也是continual Learning,也是incremental learning

目录

Life-Long Learning vs Transfer Learning

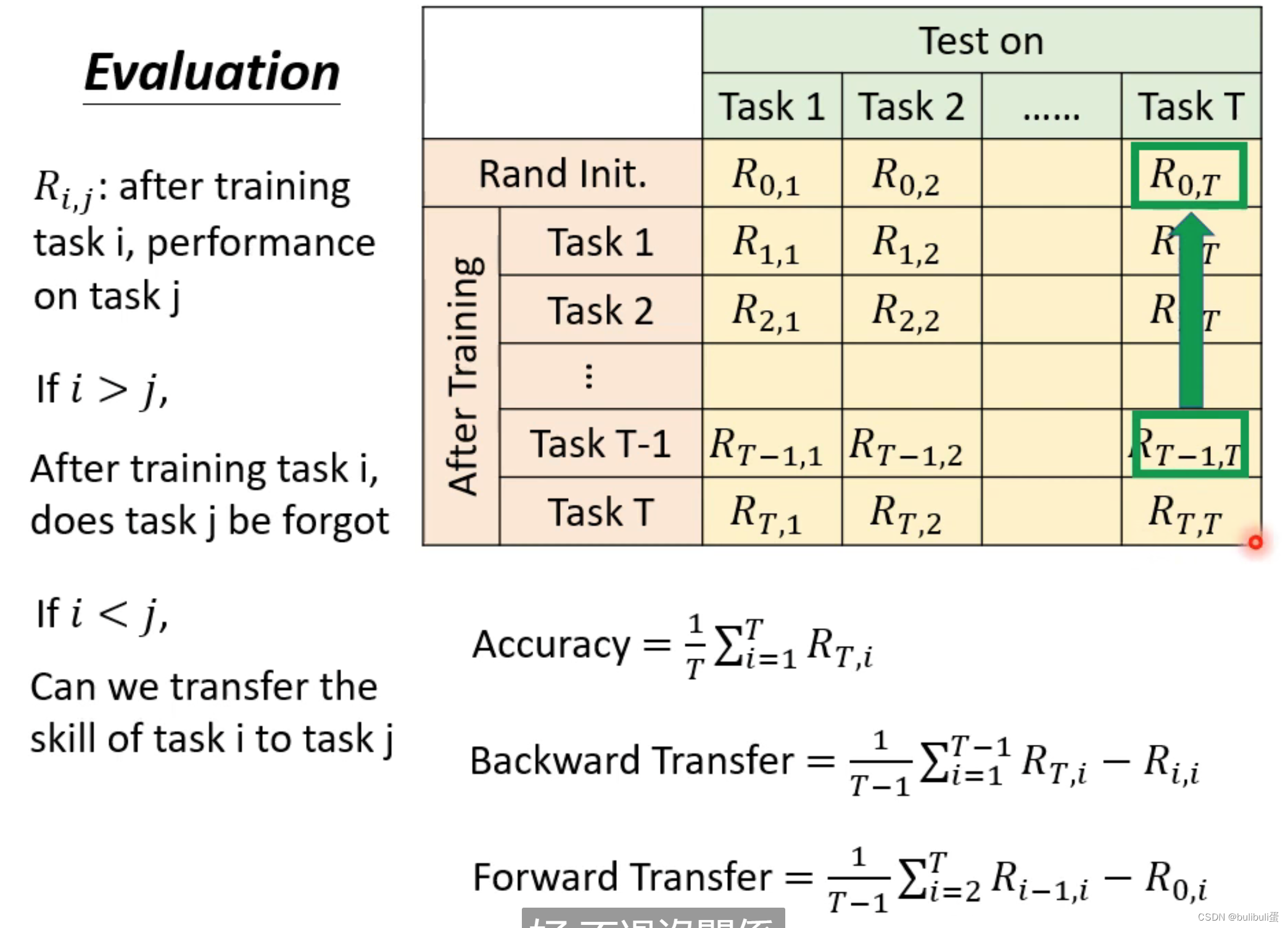

Evaluation

Research Directions

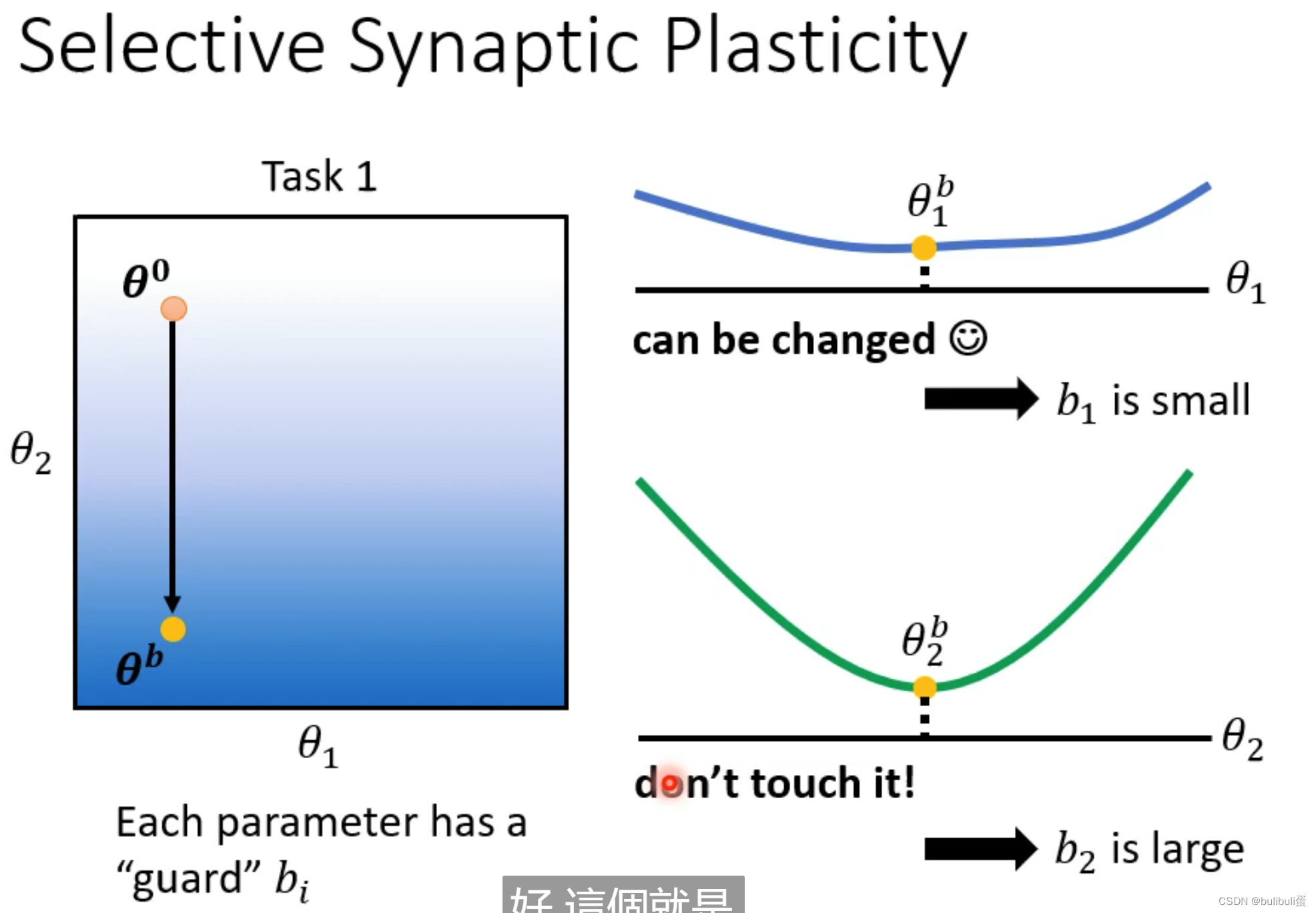

Selective Synaptic Plasticity——Regulization Based

Additional Neural Resourcr Allocation

Memory Reply

Life-Long Learning vs Transfer Learning

Transfer Learning:在任务一上学到的内容Transfer到任务二,关注点在Task2

Life-Long Learning:学完Task2以后Task1还能否work

Evaluation

Research Directions

Selective Synaptic Plasticity——Regulization Based

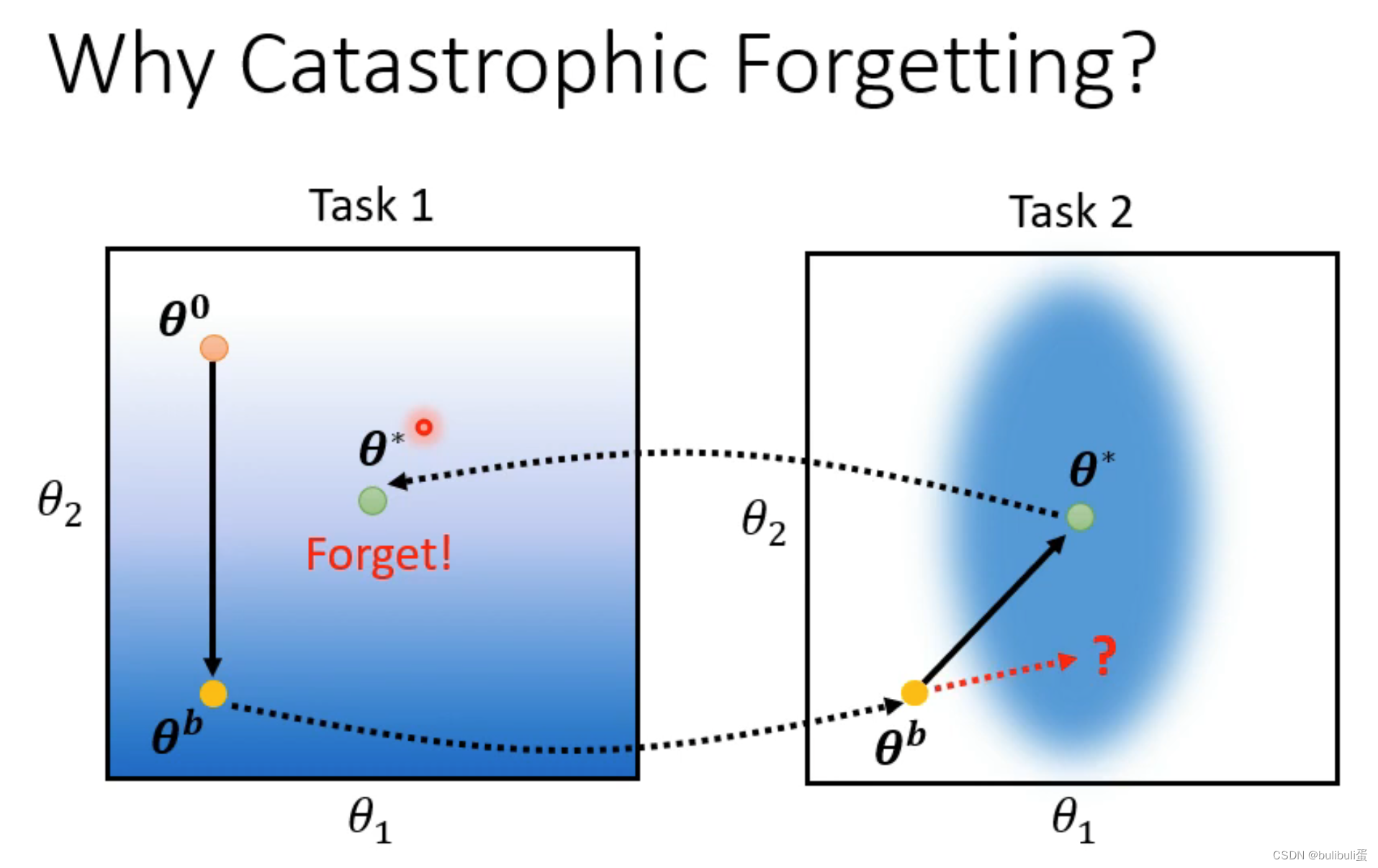

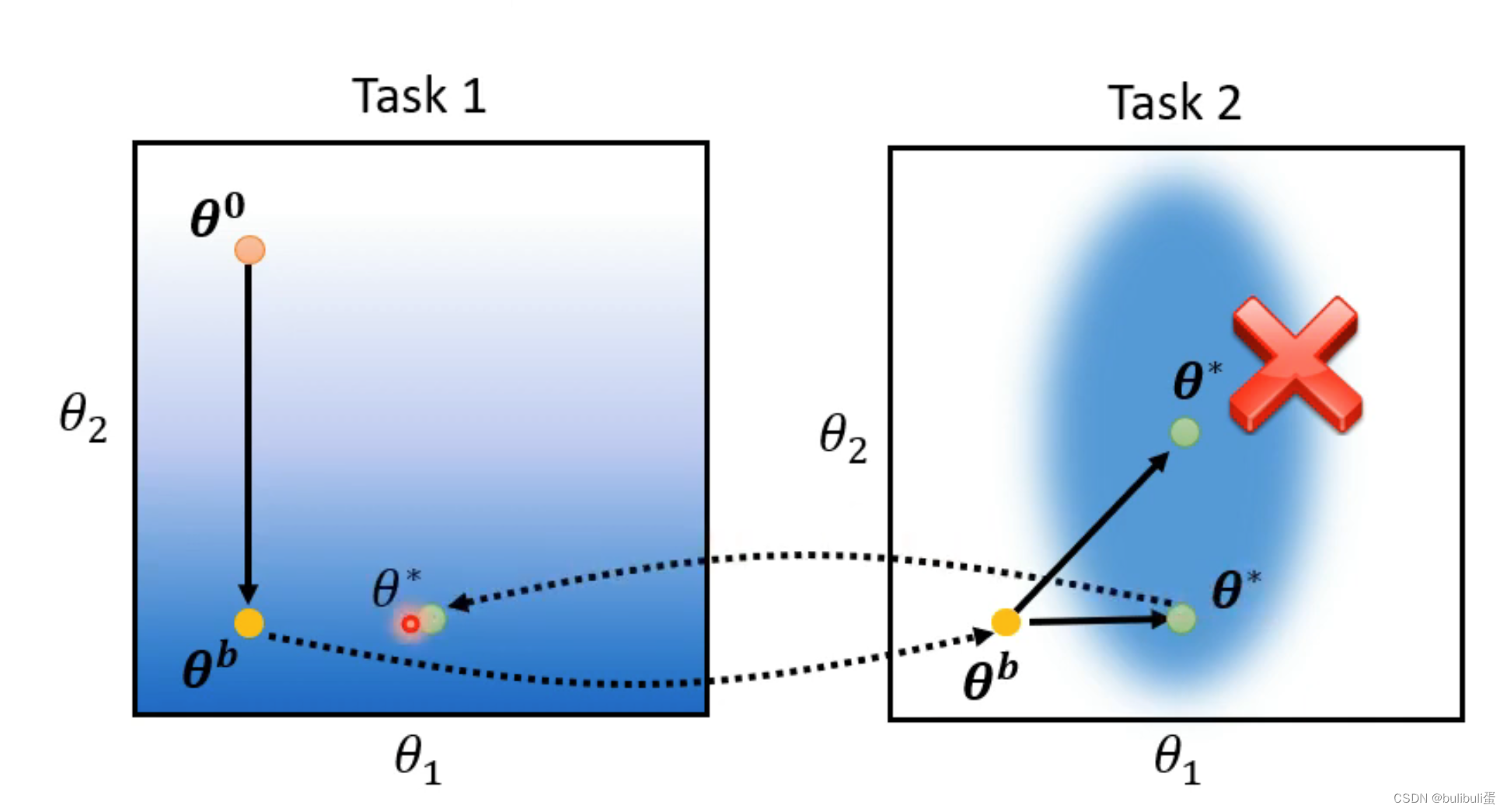

Forget的原因:白色——loss越大,蓝色——loss越小,先让模型训练task1,随机训练的参数θ0,然后使用梯度下降的方法调整θ0的参数,得到θb。将θb的参数迁移到Task2,继续训练得到θ*。将θ*应用于task1发现loss变大,说明出现了forget现象。如果将θb往右移是否在task1上效果更好呢?(往右移也是蓝色区域)

basic idea:对先前任务重要的一些参数不要改变,只需要调整不重要的参数。

是先前任务学习到的参数,对每一个参数

设置一个守卫

,代表该参数对过去的任务是否重要。

指的是将要被此任务学习得到的参数,下式为改写后的loss function,第二个式子表示该参数的重要程度:

——catastrophic forgetting

——instransigence

如何设置 ?

方向上loss变化很小,b1很小;

方向上loss变化比较大,b2较大。

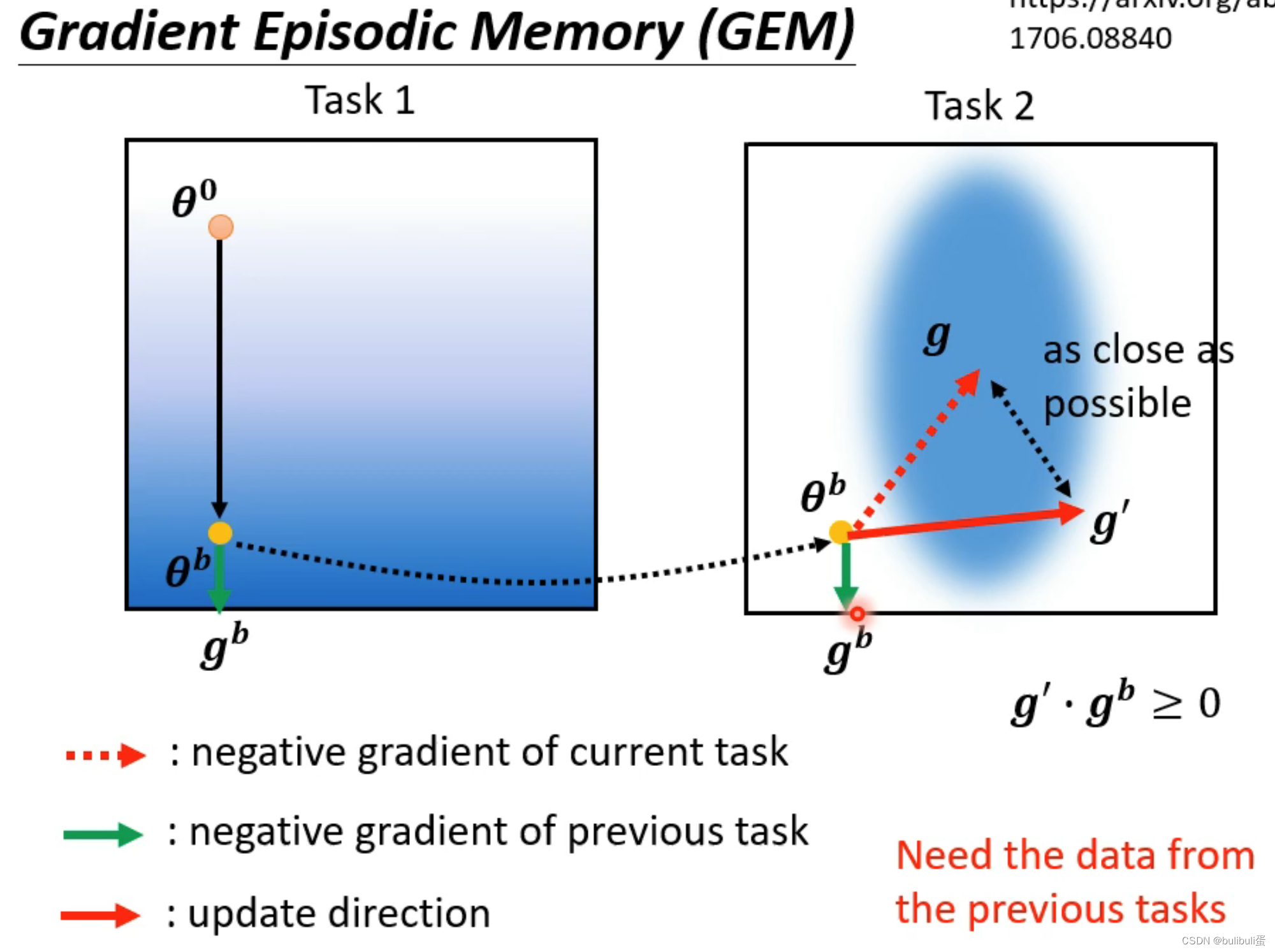

Gradient Episodic Memory (GEM)

通过存少量资料updata direction。

Additional Neural Resourcr Allocation

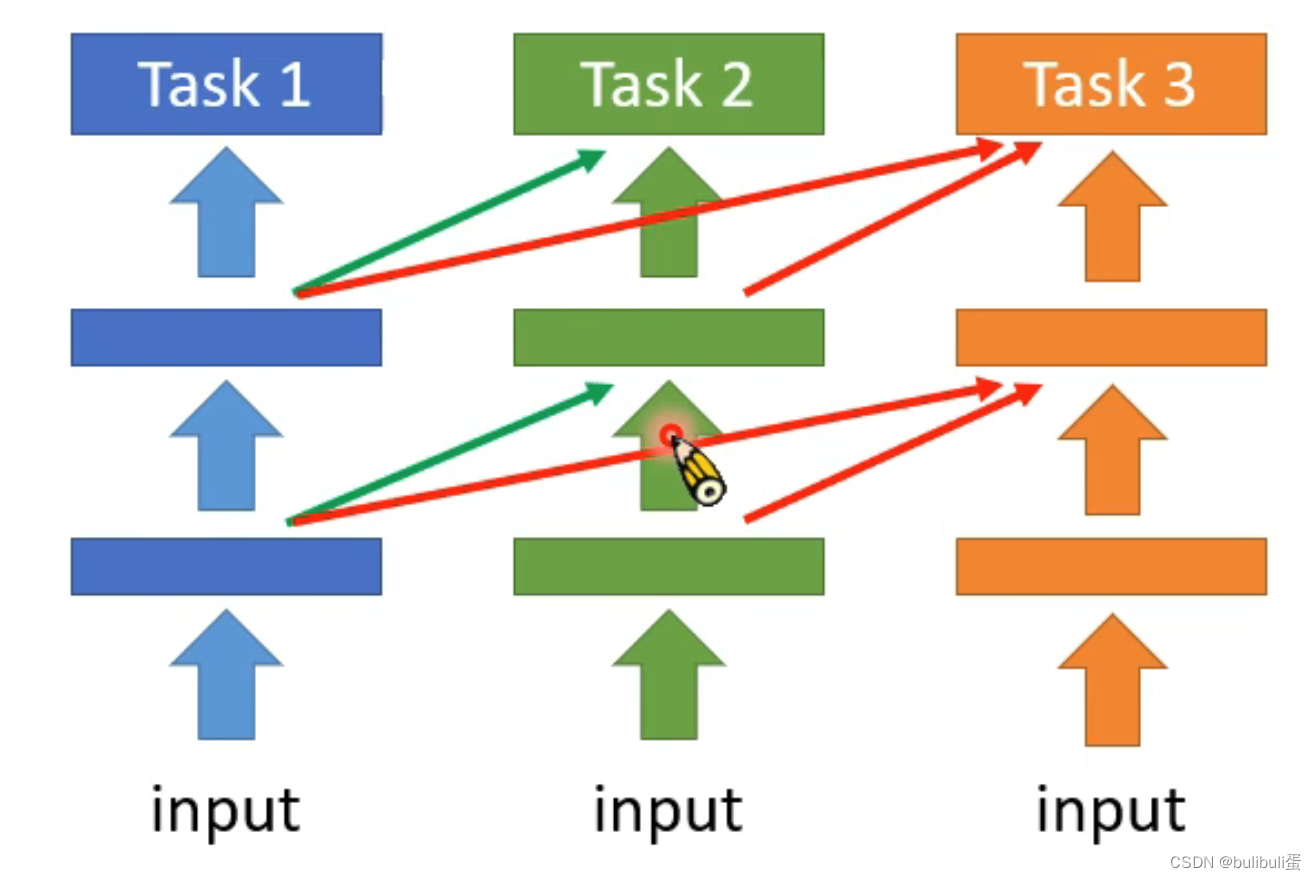

Progressive Neural Networks

只训练当前模型的参数,只是将前面模型的参数作为输入,缺点:占用过多额外空间。

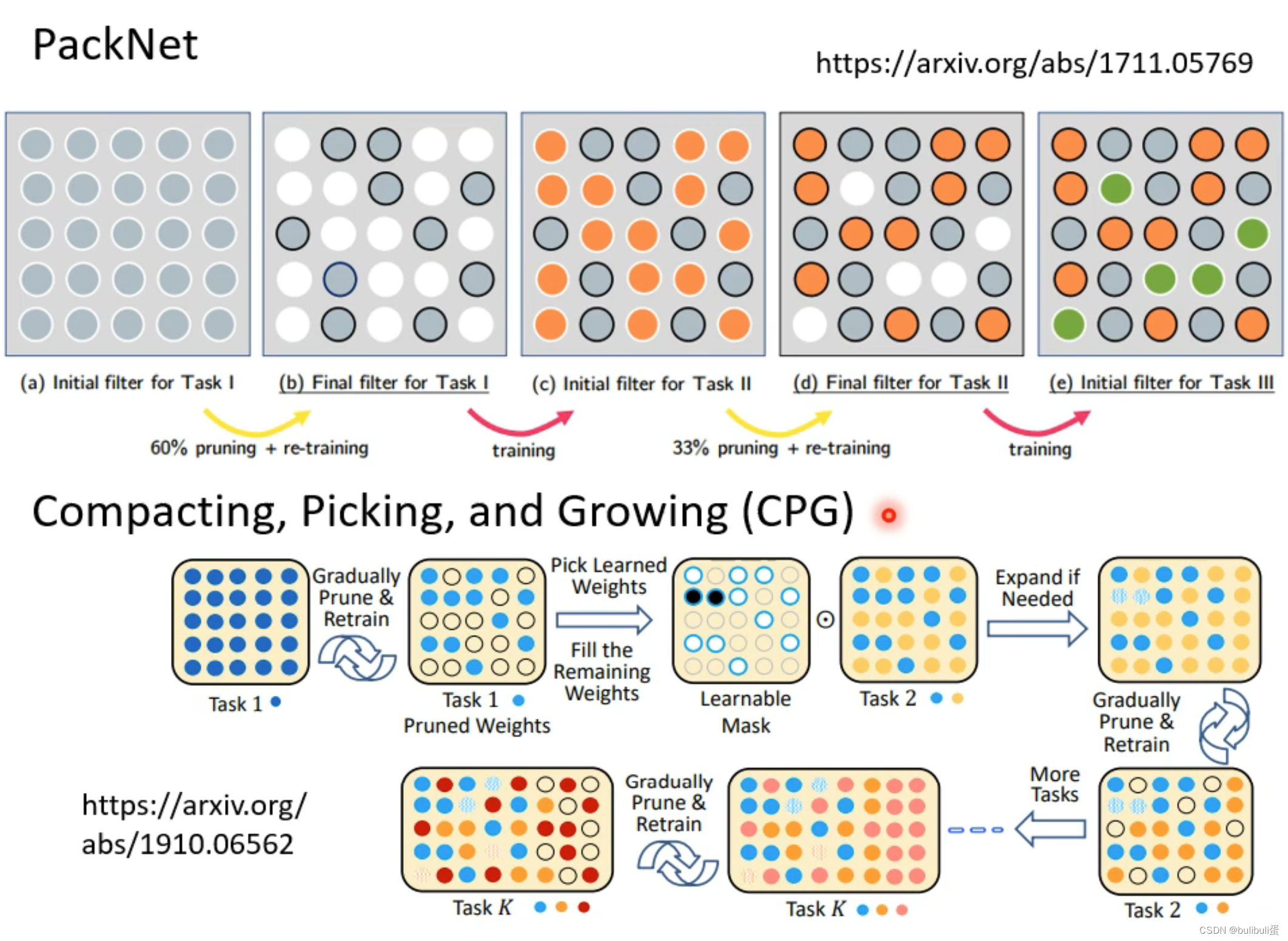

PackNet:开一个大的网络但每次task只占用其中一部分,参数保留一小部分

CPG:结合上述两种方法,既进行参数的dropout,也开辟网络空间

Memory Reply

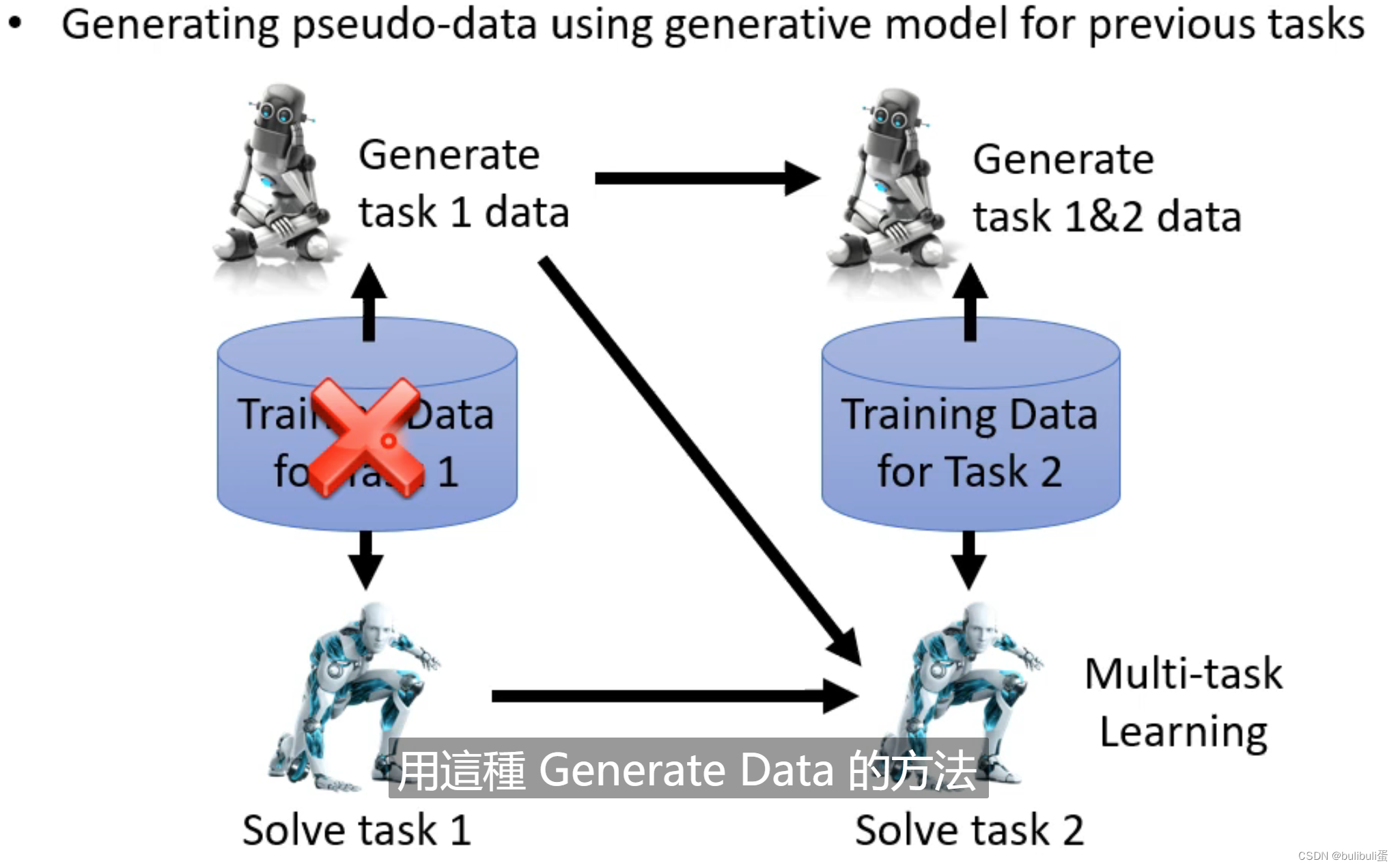

Generating data

生成先前任务的学习资料来用于现在任务的训练。

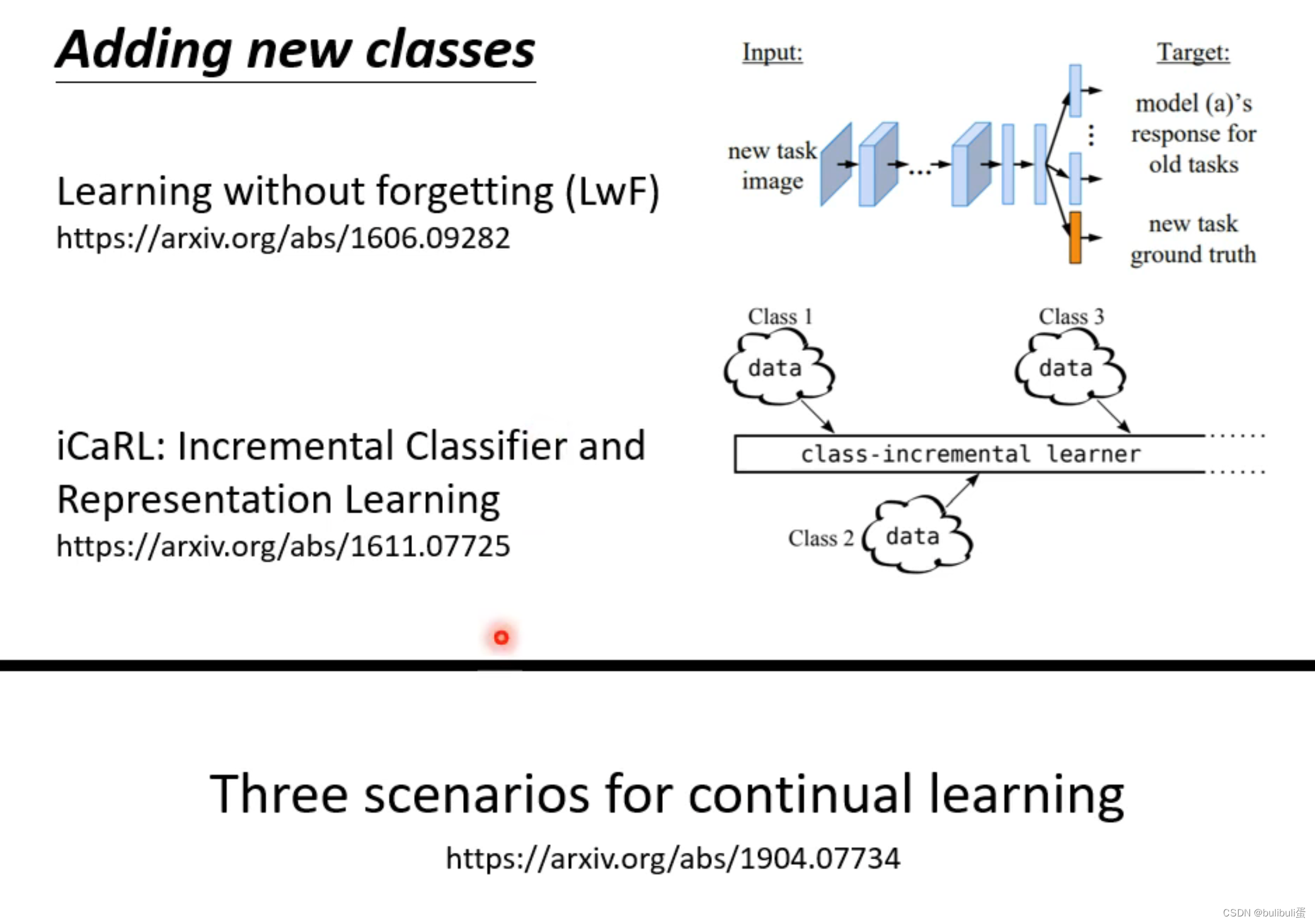

增加新class方法: