大数据处理技术导论(7) | Datawhale组队学习46期

创始人

2024-05-29 05:32:16

文章目录

- 7. spark 理论学习总结

- 7.1 spark 与 hadoop 框架区别

- 7.2 spark 编程模型 RDD

- 7.3 spark 结构原理

- 2. spark 实战

项目地址 https://github.com/datawhalechina/juicy-bigdata,感谢项目团队的付出。

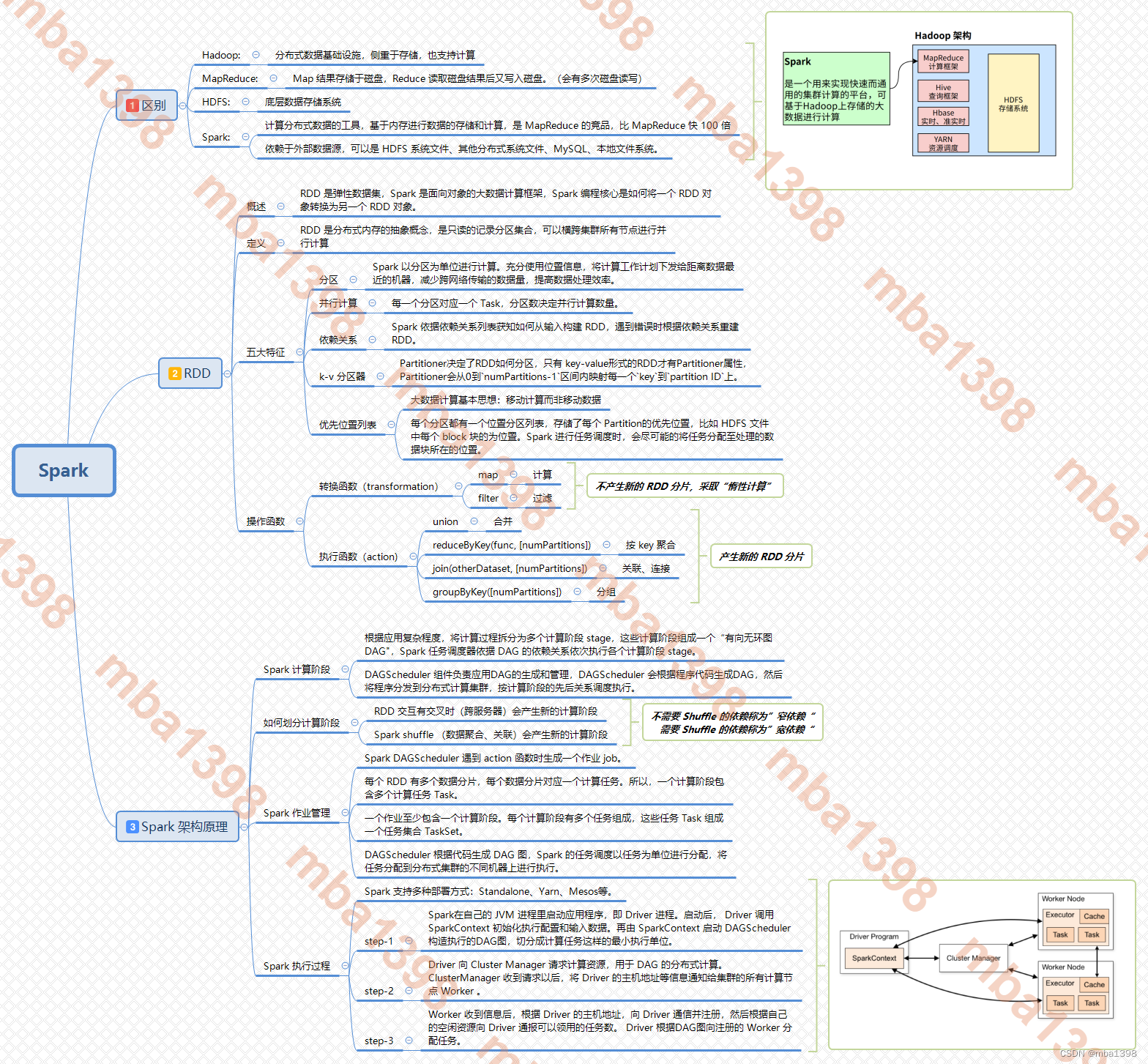

本次主要学习 spark 相关内容。本章节以思维导图的方式呈现课程学习内容。详见下图:

7. spark 理论学习总结

7.1 spark 与 hadoop 框架区别

7.2 spark 编程模型 RDD

7.3 spark 结构原理

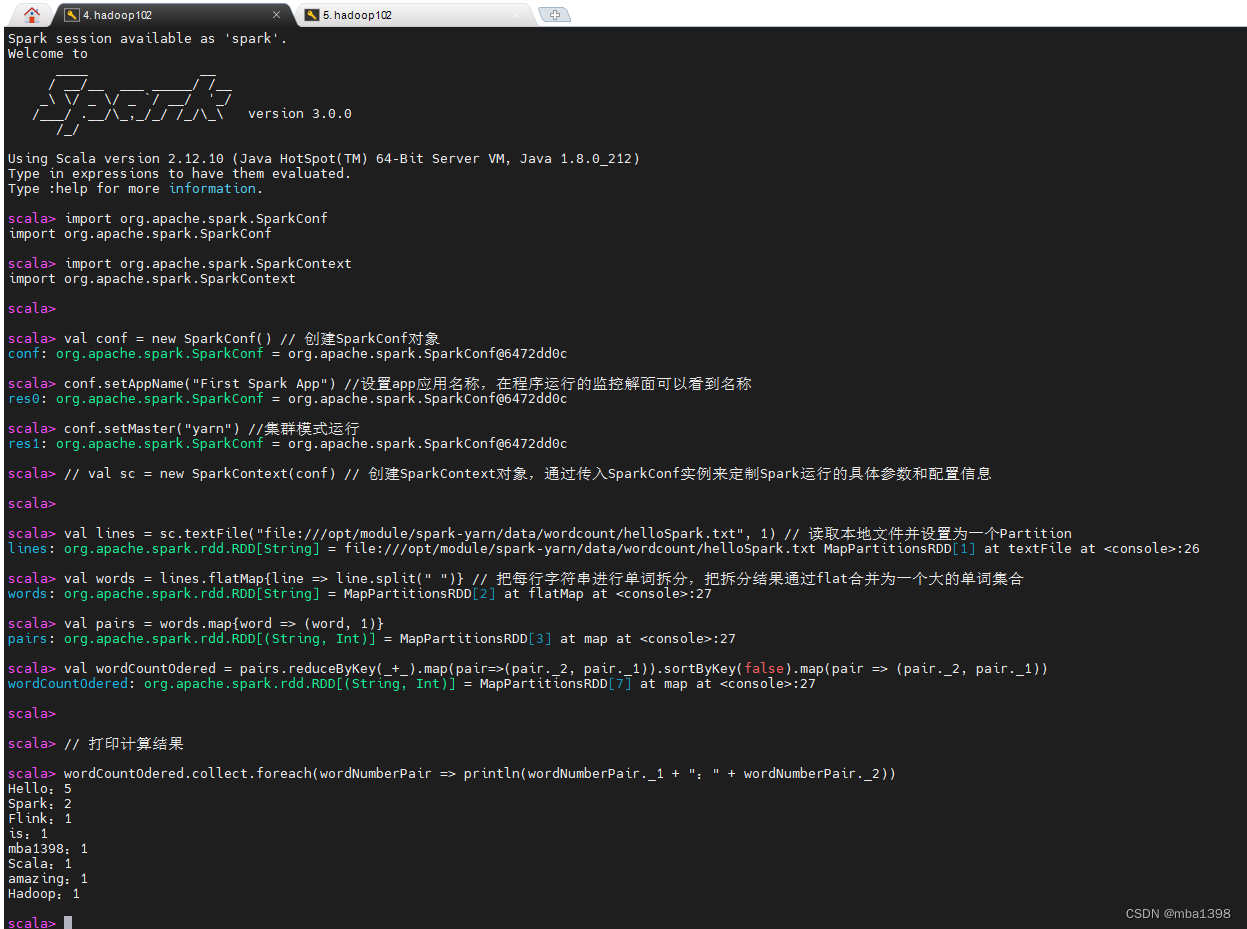

2. spark 实战

直接部署了集群模式的 spark ,

import org.apache.spark.SparkConf

import org.apache.spark.SparkContextval conf = new SparkConf() // 创建SparkConf对象

conf.setAppName("First Spark App") //设置app应用名称,在程序运行的监控解面可以看到名称

conf.setMaster("yarn") //集群模式运行

// val sc = new SparkContext(conf) // 创建SparkContext对象,通过传入SparkConf实例来定制Spark运行的具体参数和配置信息val lines = sc.textFile("file:///opt/module/spark-yarn/data/wordcount/helloSpark.txt", 1) // 读取本地文件并设置为一个Partitionval words = lines.flatMap{line => line.split(" ")} // 把每行字符串进行单词拆分,把拆分结果通过flat合并为一个大的单词集合

val pairs = words.map{word => (word, 1)}

val wordCountOdered = pairs.reduceByKey(_+_).map(pair=>(pair._2, pair._1)).sortByKey(false).map(pair => (pair._2, pair._1))wordCountOdered.collect.foreach(wordNumberPair => println(wordNumberPair._1 + ":" + wordNumberPair._2))

相关内容

热门资讯

世界上最漂亮的人 世界上最漂亮...

此前在某网上,选出了全球265万颜值姣好的女性。从这些数量庞大的女性群体中,人们投票选出了心目中最美...

北京的名胜古迹 北京最著名的景...

北京从元代开始,逐渐走上帝国首都的道路,先是成为大辽朝五大首都之一的南京城,随着金灭辽,金代从海陵王...

苗族的传统节日 贵州苗族节日有...

【岜沙苗族芦笙节】岜沙,苗语叫“分送”,距从江县城7.5公里,是世界上最崇拜树木并以树为神的枪手部落...

猫咪吃了塑料袋怎么办 猫咪误食...

你知道吗?塑料袋放久了会长猫哦!要说猫咪对塑料袋的喜爱程度完完全全可以媲美纸箱家里只要一有塑料袋的响...