简单理解TransFormer

创始人

2024-05-30 18:42:56

背景:听了李宏毅老师关于transformer的讲解,觉得有必要记录一下,里面的PPT都是李宏毅老师的内容(不喜勿喷)

1.self-attention

在介绍transformer之前,必须先了解self-attention

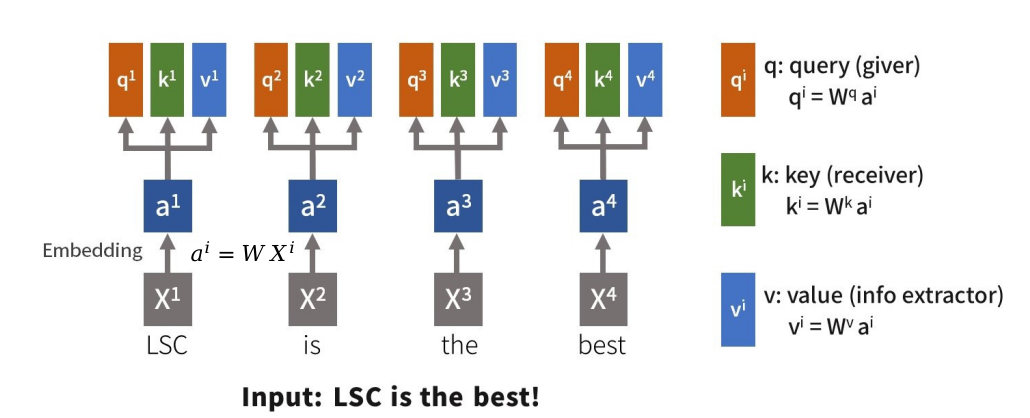

(1) 先将X输入Embedding(a = Wx), 然后a乘相关的权重,生成QKV

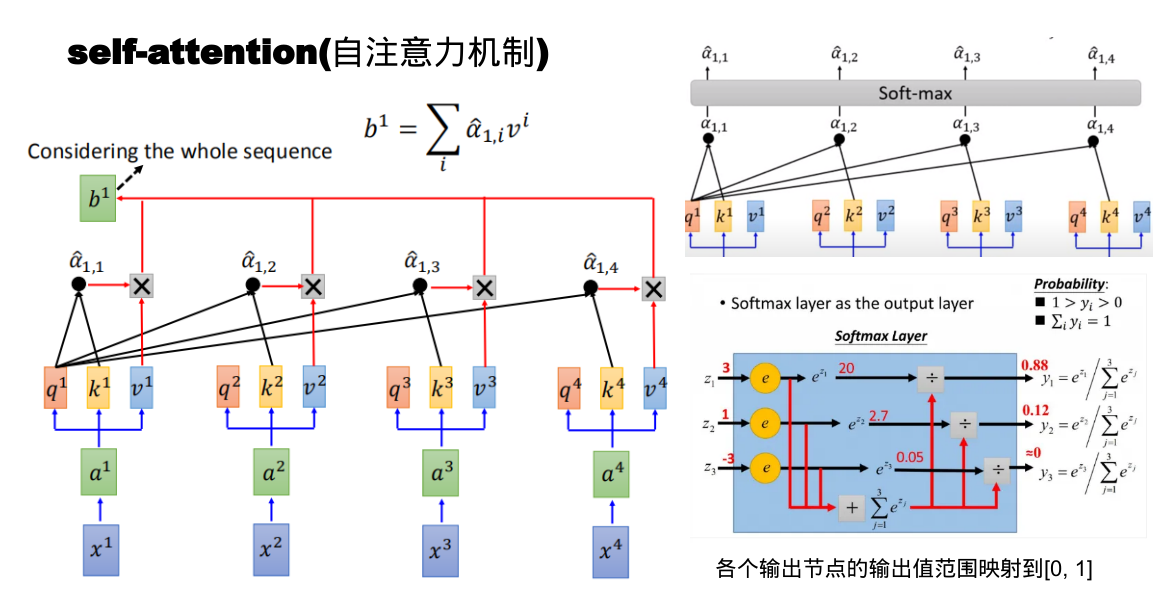

(2) q1*k1、q1*k2...,将q1*k1、q1*k2...通过soft-max,然后将通过soft-max的数值与V相乘,最后将相乘的结果相加生成b1、b2...

(3) 根据(1)和(2)就是self-attention的操作(这样说还是挺清楚的,公式也不复杂)

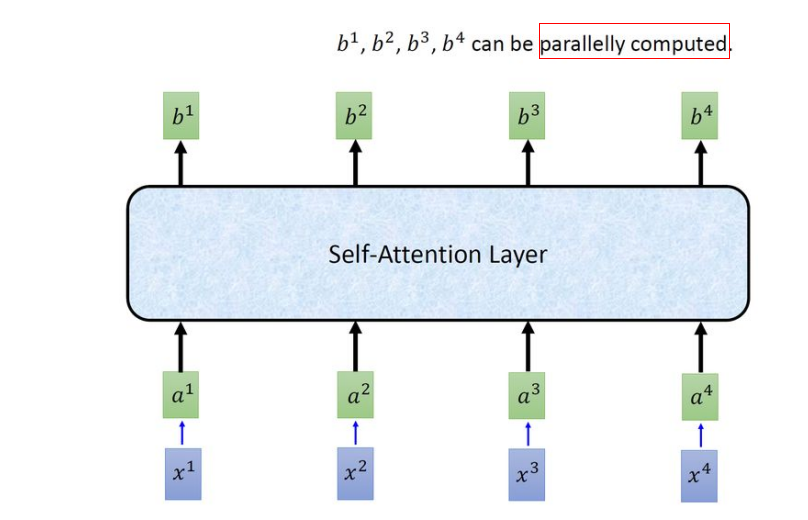

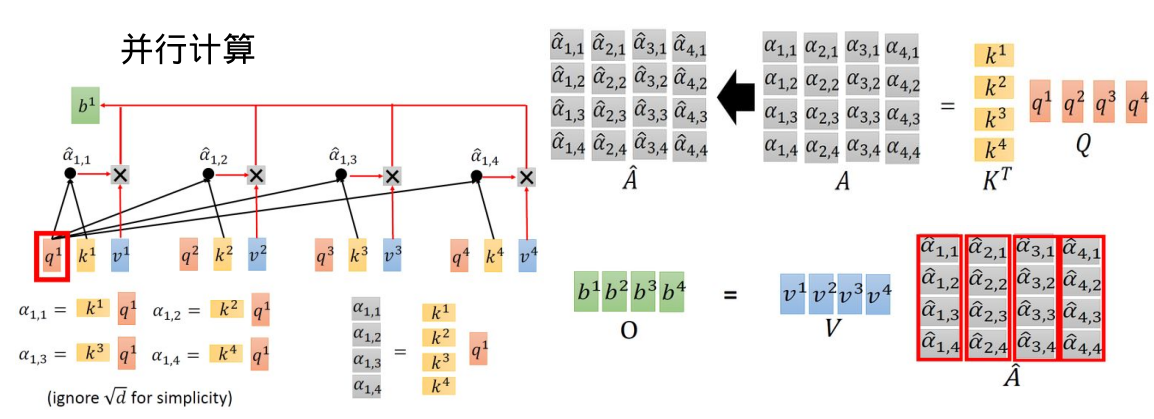

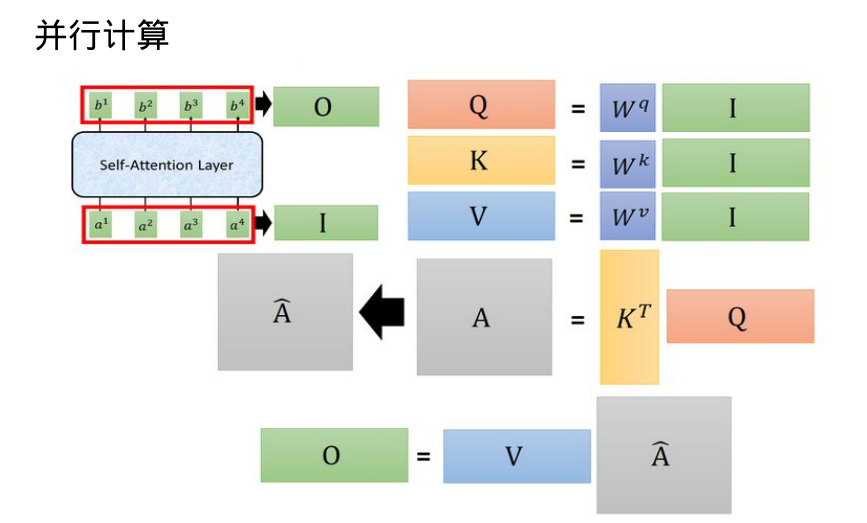

2.并行计算

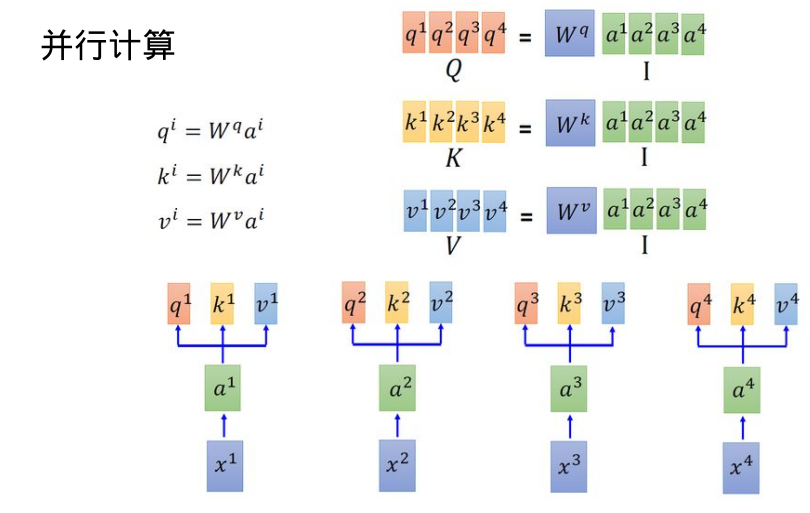

(1) 矩阵的计算还是挺清楚的(QKV的计算)

(2) 计算b(softmax(K*Q)*V最后相加)

(3) 简化的就是这样,大块的清清楚楚!!!

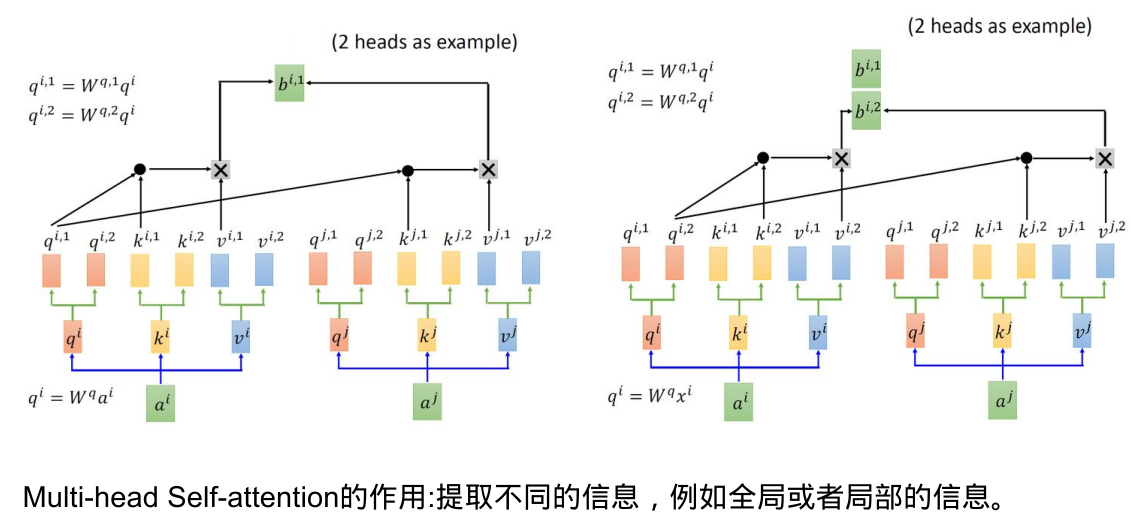

3.多头注意力机制

(1) 多个QKV

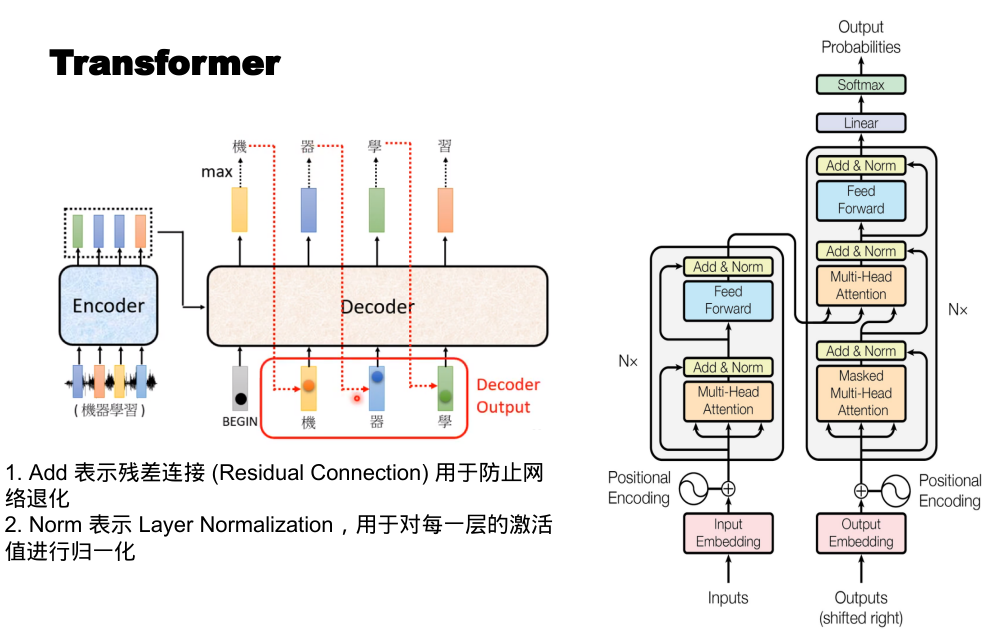

4.TransFormer

5.注意点

关于这个图,理解的理解,不理解的还是不理解

从vit的onnx结构图来看transformer的输入

3*224*224经过768个16*16的卷积,输出768*14*14

将输出flatten,768*196(14*14)

调整通道196*768

添加class_num(分类信息)1*768,拼接196*768成197*768

添加位置信息pos,add(shape还是197*768)

关于outputs的解释

我的理解就是encoder的输出,如下图所示

encoder从BOS(一个特殊的字符)开始,输出潮水

decoder从BOS+潮水作为encoder的outputs,但是是decoder的inputs

重复几遍,知道潮水退了结束

3.VIT的onnx结构图

看看里面的结构,都是一些block的堆叠,也没有新的OP,我的感觉是transformer还是做的和CNN的工作是类似的,但是transformer的并行效果更好,同时这些计算密集型的OP,后续的性能优化也是一个方向(量化)

下一篇:Singleton模式

相关内容

热门资讯

北京的名胜古迹 北京最著名的景...

北京从元代开始,逐渐走上帝国首都的道路,先是成为大辽朝五大首都之一的南京城,随着金灭辽,金代从海陵王...

苗族的传统节日 贵州苗族节日有...

【岜沙苗族芦笙节】岜沙,苗语叫“分送”,距从江县城7.5公里,是世界上最崇拜树木并以树为神的枪手部落...

长白山自助游攻略 吉林长白山游...

昨天介绍了西坡的景点详细请看链接:一个人的旅行,据说能看到长白山天池全凭运气,您的运气如何?今日介绍...

应用未安装解决办法 平板应用未...

---IT小技术,每天Get一个小技能!一、前言描述苹果IPad2居然不能安装怎么办?与此IPad不...

脚上的穴位图 脚面经络图对应的...

人体穴位作用图解大全更清晰直观的标注了各个人体穴位的作用,包括头部穴位图、胸部穴位图、背部穴位图、胳...