HDFS核心参数配置

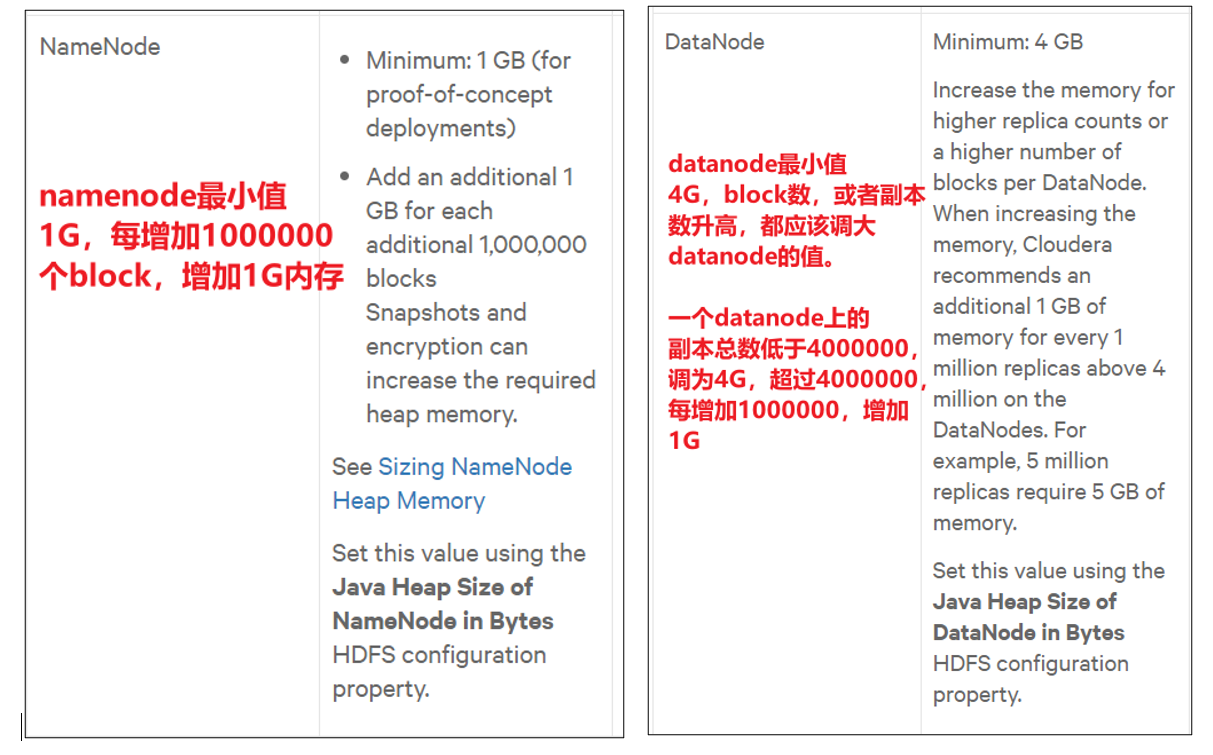

1、Hadoop3.x系列,NameNode内存生产配置

可以通过以下命令来获取相应的内存信息

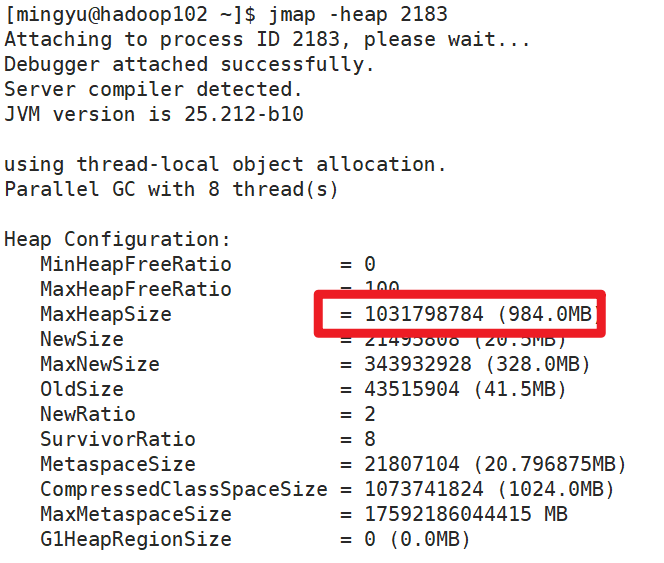

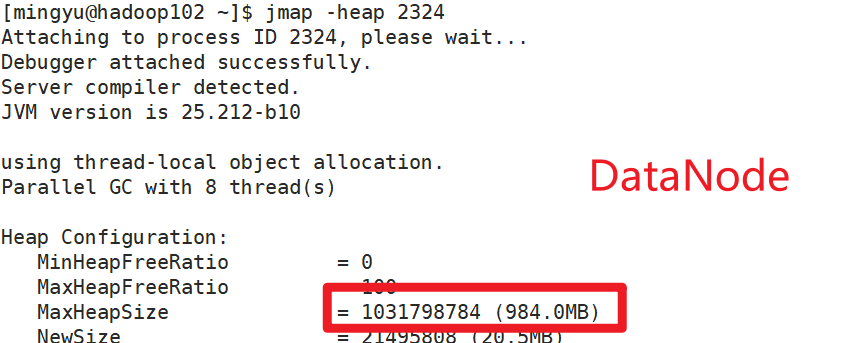

jmap -heap 进程号jmap -heap 6443

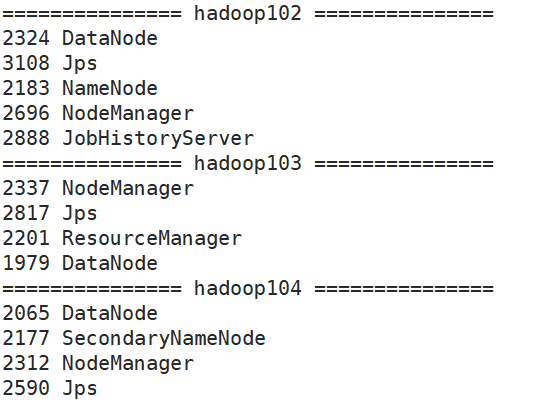

可以看到HDFS默认的NameNode和DataNode节点内存配置最大984M,据官方的配置文件etc/hadoop/hadoop-env.sh可知:

###

# NameNode specific parameters

#### Default log level and output location for file system related change

# messages. For non-namenode daemons, the Java property must be set in

# the appropriate _OPTS if one wants something other than INFO,NullAppender

# Java property: hdfs.audit.logger

# export HDFS_AUDIT_LOGGER=INFO,NullAppender# Specify the JVM options to be used when starting the NameNode.

# These options will be appended to the options specified as HADOOP_OPTS

# and therefore may override any similar flags set in HADOOP_OPTS

#

# a) Set JMX options

# export HDFS_NAMENODE_OPTS="-Dcom.sun.management.jmxremote=true -Dcom.sun.management.jmxremote.authenticate=false -Dcom.sun.management.jmxremote.ssl=false -Dcom.sun.management.jmxremote.port=1026"

#

# b) Set garbage collection logs

# export HDFS_NAMENODE_OPTS="${HADOOP_GC_SETTINGS} -Xloggc:${HADOOP_LOG_DIR}/gc-rm.log-$(date +'%Y%m%d%H%M')"

#

# c) ... or set them directly

# export HDFS_NAMENODE_OPTS="-verbose:gc -XX:+PrintGCDetails -XX:+PrintGCTimeStamps -XX:+PrintGCDateStamps -Xloggc:${HADOOP_LOG_DIR}/gc-rm.log-$(date +'%Y%m%d%H%M')"# this is the default:

# export HDFS_NAMENODE_OPTS="-Dhadoop.security.logger=INFO,RFAS"Hadoop里面NameNode和DataNode是动态分配的(hadoop3.x),并且都是984M

使用以下配置信息来修改此项配置

export HDFS_NAMENODE_OPTS="-Dhadoop.security.logger=INFO,RFAS -Xmx1024m"export HDFS_DATANODE_OPTS="-Dhadoop.security.logger=ERROR,RFAS -Xmx1024m"2、Hadoop2.x系列,配置NameNode内存

NameNode内存默认2000m,如果服务器内存4G,NameNode内存可以配置3g。在hadoop-env.sh文件中配置如下。

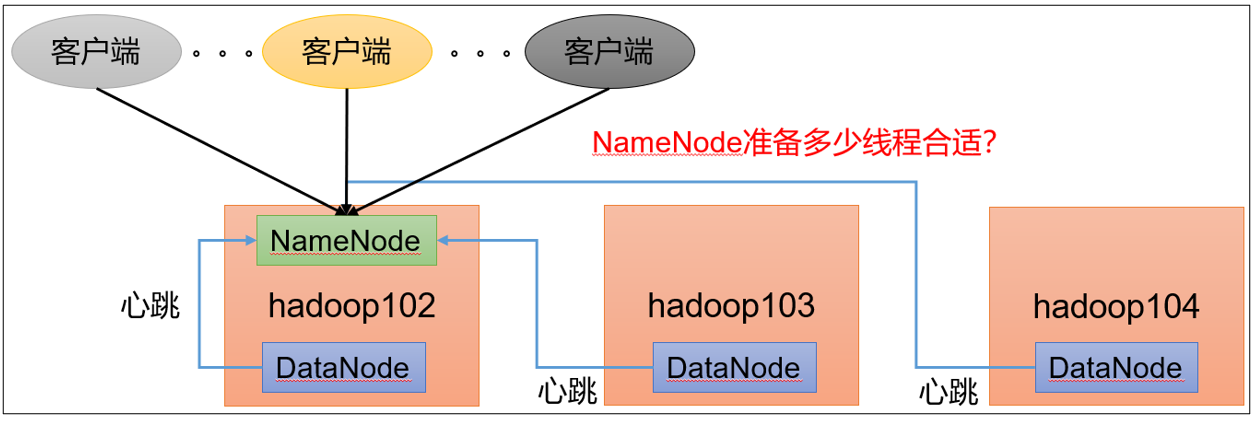

HADOOP_NAMENODE_OPTS=-Xmx3072m3、NameNode心跳并发配置

hdfs-site.xml

The number of Namenode RPC server threads that listen to requests from clients. If dfs.namenode.servicerpc-address is not configured then Namenode RPC server threads listen to requests from all nodes.

NameNode有一个工作线程池,用来处理不同DataNode的并发心跳以及客户端并发的元数据操作。

对于大集群或者有大量客户端的集群来说,通常需要增大该参数。默认值是10。

dfs.namenode.handler.count 21

企业经验:dfs.namenode.handler.count=20×logeCluster Size![]() ,比如集群规模(DataNode台数)为3台时,此参数设置为21。可通过简单的python代码计算该值,代码如下。

,比如集群规模(DataNode台数)为3台时,此参数设置为21。可通过简单的python代码计算该值,代码如下。

>>> import math

>>> print int(20*math.log(3))

21

>>> quit()4、开启回收站配置

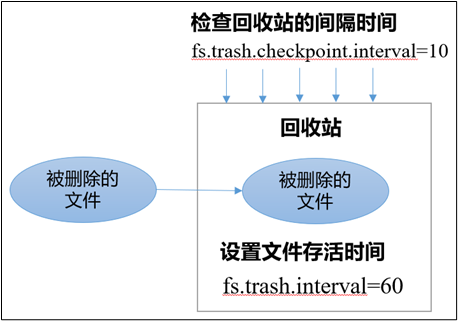

开启回收站功能,可以将删除的文件在不超时的情况下,恢复原数据,起到防止误删除、备份等作用。

1)回收站工作机制

2)开启回收站功能参数说明

(1)默认值fs.trash.interval = 0,0表示禁用回收站;其他值表示设置文件的存活时间。

(2)默认值fs.trash.checkpoint.interval = 0,检查回收站的间隔时间。如果该值为0,则该值设置和fs.trash.interval的参数值相等。

(3)要求fs.trash.checkpoint.interval <= fs.trash.interval。

3)启用回收站

修改core-site.xml,配置垃圾回收时间为60分钟。

fs.trash.interval 60

fs.trash.checkpoint.interval 10

[mingyu@hadoop102 hadoop-3.1.3]$ hadoop fs -rm /a.txt

2023-03-13 09:16:36,316 INFO fs.TrashPolicyDefault: Moved: 'hdfs://hadoop102:8020/a.txt' to trash at: hdfs://hadoop102:8020/user/mingyu/.Trash/Current/a.txt

4)查看回收站

回收站目录在HDFS集群中的路径:/user/mingyu/.Trash/….

5)注意:通过网页上直接删除的文件也不会走回收站。

6)通过程序删除的文件不会经过回收站,需要调用moveToTrash()才进入回收站

7)只有在命令行利用hadoop fs -rm命令删除的文件才会走回收站。

8)恢复回收站数据

hadoop fs -mv /user/mingyu/.Trash/Current/新建文本文档.txt /

上一篇:单片机学习笔记

下一篇:Matlab导出为 CDF 文件