Anatomy-Guided Weakly-Supervised Abnormality Localization in Chest X-rays

文章来源:[MICCAI 2022]

代码:https://github.com/batmanlab/AGXNet

Keywords:Weakly-supervised learning(WSL), disease localization, disease classification

本文提出的两个challenges:

- 整个报告通常被总结为一小部分疾病标签,错过了结合解剖学背景的机会。即本文所说的anatomy。

- 由于标签的稀疏性和语言的模糊性,使用自然语言处理(NLP)从放射学报告中导出的弱标签是有噪声的。

1、Intorduction

本文提出了Anatomy- Guided chest X-ray Network (AGXNet)的架构来解决弱标注问题。通过两个级联网络,第一个用于识别anatomical abnormalities,第二个用于pathological observations。利用一个anatomy-guided attention模块辅助observation网络关注由anatomy网络生成的相关anatomical区域。

如上图所示,其实是由两个分类网络组成,ga为anatomical abnormalities,go为pathological observations。

两个 text labelers: Chest ImaGenome 和 RadGraph

本文是基于RadGraph。

对于CXR报告,解析“observation-located atanatomy” relations, (e.g., “opacity in the right lower lung”)。这里的opacity即是observation,lung为ananatomy,right lower为修饰lung。

针对第2个挑战,CXR报告中弱标签有噪声

由于内在的歧义性,CXR报告中提到了肺炎的视觉线索,如不透明或实变,但由于报告过程中的人为因素,可能无法明确确定肺炎是一种诊断。我们还认为不确定性提及(例如,may, possible, can`t exclude)是未标记的。

我们将这个问题公式化为Positive Unlabeled (PU) learning,其中可以通过一小组具有高置信度标签(阳性或阴性)的样本,以及大量未标记的数据,这些数据由混合比例未知的阳性和阴性样本混合而成。

2、Method

Report Representation

Anatomy Network

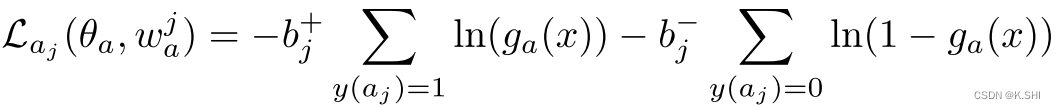

ga用于从 anatomical landmarks中识别异常,使用带有权重的BCE loss。

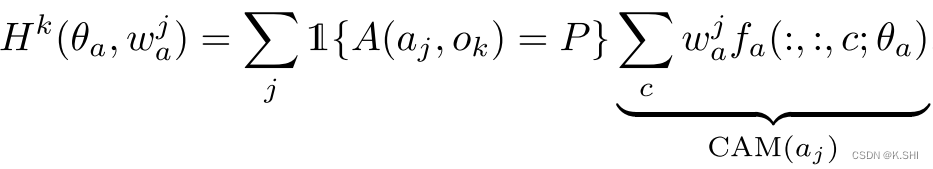

AGA

指导第二部分的observation network 关注相关的anatomical区域。在anatomy feature map中激活channel c。

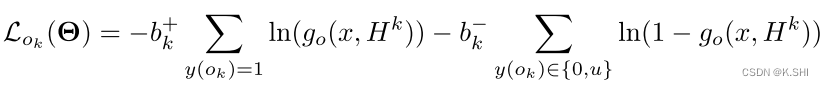

Observation Network

用于识别CXR图像中的病理部分,

PU Learning

无标签数据 Pu 可以被解耦成Pu = αPp + (1 − α)Pn

Optimization

最后的Loss由两部分组成,Na, No 为 anatomy and observation labels 在训练中使用的数量。

推理时不需要任何的text输入,Hk=0。