2023-03-22干活小计:

创始人

2025-06-01 14:09:02

transformer:

position-embedding:

残差:我也会了

addnorm:我也会了

class Position_Embedding(nn.Module):def __init__(self, max_len, embedding_dim):self.max_len = max_lenself.embedding_dim = embedding_dimresult = torch.ones(self.max_len, self.embedding_dim, requires_grad=False)pos = torch.arange(max_len)[:, None]i_even = torch.arange(0, embedding_dim, 2)[None, :]i_odd = torch.arange(1, embedding_dim, 2)[None, :]even_value = pos / (10000**(2*i_even/self.embedding_dim))odd_value = pos / (10000**(2*i_odd/self.embedding_dim))result[:, 0::2] = torch.sin(even_value)result[:, 1::2] = torch.cos(odd_value)self.position_embedding = resultdef forward(self, x):position_embedding = x + self.position_embeddingreturn position_embedding

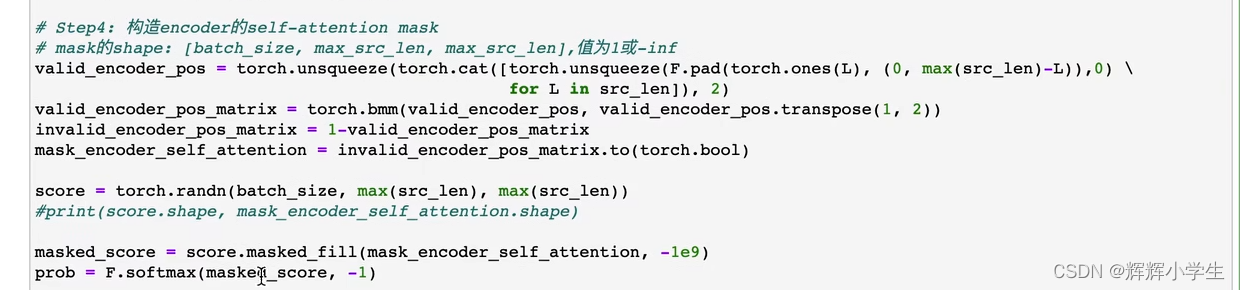

self-attention以及mask-padding部分:

周末忙完了自己实现一遍,带进任务,看看效果。

attention组合位置信息,全连接组合特征信息

transformer中的masked loss:不要算pad部分的loss tf中有对应的函数(也可以利用CROSSentropy的一个ignore参数)

上一篇:verilog(基础知识)

下一篇:【Linux】-- 进程概念

相关内容

热门资讯

苗族的传统节日 贵州苗族节日有...

【岜沙苗族芦笙节】岜沙,苗语叫“分送”,距从江县城7.5公里,是世界上最崇拜树木并以树为神的枪手部落...

长白山自助游攻略 吉林长白山游...

昨天介绍了西坡的景点详细请看链接:一个人的旅行,据说能看到长白山天池全凭运气,您的运气如何?今日介绍...

应用未安装解决办法 平板应用未...

---IT小技术,每天Get一个小技能!一、前言描述苹果IPad2居然不能安装怎么办?与此IPad不...

世界上最漂亮的人 世界上最漂亮...

此前在某网上,选出了全球265万颜值姣好的女性。从这些数量庞大的女性群体中,人们投票选出了心目中最美...

脚上的穴位图 脚面经络图对应的...

人体穴位作用图解大全更清晰直观的标注了各个人体穴位的作用,包括头部穴位图、胸部穴位图、背部穴位图、胳...